Hintergrund

Die rasante Entwicklung von Automatisierungstechnologien im Cockpit sowie die Integration neuester Sensor- und Informationssysteme erhöhen stetig die kognitive Komplexität von Flugmissionen. Im Cockpit der Zukunft stehen Pilotinnen und Piloten vor der anspruchsvollen Aufgabe, eine Vielzahl von fliegerischen und militärischen Herausforderungen zeitgleich bewältigen, die zusätzlich taktisch im Team koordiniert werden müssen.

Dabei wird Multitasking – die gleichzeitige Ausführung mehrerer Aufgaben – zur unverzichtbaren Fähigkeit, um diese Herausforderungen erfolgreich bewältigen zu können. Die Modellierung und Vorhersage des Multitaskingverhaltens von Pilotinnen und Piloten bei Ausführung missionstypischer Aufgaben ist der Schlüssel zur Entwicklung neuer kognitiver Assistenzsysteme, welche Pilotinnen und Piloten bei der Erreichung vielfältiger Missionsziele unterstützen, und somit die Effizienz und Sicherheit von Flugmissionen erhöhen.

Unser Modellierungsansatz

Die Berücksichtigung von kognitiver Kontrolle - der Fähigkeit, aufgabenrelevante Ziele trotz potenzieller Ablenkungen effizient zu erreichen - wird bei klassischen, ressourcenbasierten Ansätzen zur Modellierung von Multitaskingverhalten im Cockpit vernachlässigt. Unsere Forschung untersucht den Zusammenhang zwischen unterschiedlichen Ausprägungen der kognitiven Kontrolle und der fliegerischen und militärischen Leistung unter kontrollierten Laborbedingungen sowie in realitätsnahen Virtual-Reality Flugmissionen. Im Mittelpunkt steht dabei die Analyse von Augenbewegungsdaten.

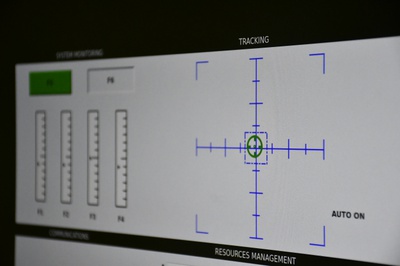

Abbildung einer Augenbewegung während einer in VR simulierten Flugmission.

Abbildung einer Augenbewegung während einer in VR simulierten Flugmission.

Mithilfe neuester Algorithmen der Künstlichen Intelligenz (Machine Learning) und der Bayesianischen Statistik haben sich diese Daten als hervorragende Prädiktoren für unterschiedliche Ausbildungsformen von kognitiver Kontrolle erwiesen. Ergänzend hierzu werden Daten zur kognitiven Leistung in den einzelnen Flugaufgaben und mentalen Arbeitsbelastung analysiert. Dieser Ansatz eröffnet neue Perspektiven zur Nutzerzustandsdiagnose im Rahmen der Entwicklung leistungsfähiger, adaptiver Assistenzsysteme. Zur Integration dieser in das Cockpit der Zukunft führen wir zudem Experimente durch, die Interaktionseffekte zwischen Ausprägungen der kognitiven Kontrolle und Systemen zur Nutzerunterstützung (z.B. (Teil-)Automatisierung von einzelnen Flugaufgaben oder 3D-Audio-Unterstützung bei der Funkkommunikation) erforschen.

Durchgeführte Mensch-Maschine-Experimente

Im Folgenden erhalten Sie einen Einblick in die konkreten Fragestellungen der durchgeführten Experimente:

Experimentelle Manipulation des Kontrollmodus mittels Gamification

In drei Experimenten mit insgesamt über 100 Versuchsteilnehmenden wurde eine neue Gamification-Methode zur Manipulation von kognitiver Kontrolle entwickelt und in einer virtuellen Flugumgebung getestet. Untersucht wurden neben Leistungs- und Augenbewegungsdaten auch demografische Einflüsse, wie eine Präferenz für Multitasking, sowie die mentale Arbeitsbelastung.

Der Co-Pilot: Schlüssel zum Erfolg?

Da Flugmissionen oft in Formation oder mit Dual-Cockpit geflogen werden, muss bei der Modellierung von Multitaskingverhalten die Unterstützung durch einen Partner einbezogen werden. Das durchgeführte Experiment untersuchte, wie sich Leistung, Augenbewegungen und mentale Arbeitsbelastung bei Unterstützung durch einen Missionspartner verändern.

Vom Labor ins Cockpit: Augenbewegungen und kognitive Kontrolle in VR-Flugmissionen

In zwei umfangreichen Studien mit über 80 Versuchsteilnehmenden wurde in unserem modernen Virtual-Reality Labor der Einfluss der kognitiven Kontrolle durch die Manipulation von Aufgabenpriorisierung und dynamischen Missionsveränderungen untersucht. Diese umfassen u.a. Tiefflüge und Variationen im Freund-Feind-Verhältnis während Aufklärungsmissionen.

Hierbei lautete die zentrale Forschungsfrage: Wie genau können die in der Laborumgebung identifizierten Eyetracking-Metriken zur Nutzerzustandsdiagnose verschiedene Ausprägungen der kognitiven Kontrolle in realitätsnahen Flugmissionen vorhersagen?

Der Weg in die Zukunft: Automatisierung und Kognitive Kontrolle im Cockpit

Auszug aus der Experimentalumgebung mit simuliertem Autopiloten.

3D-Audio im Cockpit: Evaluation eines akustischen Unterstützungssystems

Die räumliche Modulation von Funksprüchen mittels 3D-Audio bietet eine innovative Möglichkeit, die Funkkommunikation für Pilotinnen und Piloten in dynamischen Multitasking-Situationen zu unterstützen. Hierbei werden Funksprüche analog zur Position der Ursprungsschallquelle eines simulierten Formationsflug dargeboten.

In Kooperation mit der Professur für Mechatronik der HSU evaluiert eine experimentelle Studie die Unterstützungsleistung dieses Systems auf die Multitaskingleistung, die mentale Arbeitsbelastung und Augenbewegungsmuster unter verschiedenen Ausprägungen der kognitiven Kontrolle in unserer virtuellen Flugsimulationsumgebung. Dabei trägt die Studie maßgeblich zur Entwicklung eines digitalen aktiven Kopfhörersystems für Luftfahrzeuge bei.

Projektleiter

Wissenschaftliche Mitarbeiterin

Multitasking im Cockpit sowie das Stabilitäts-Flexibilitäts-Dilemma

Multitasking klingt nach der perfekten Lösung für jedes Zeitproblem. Ob es aber wirklich funktioniert, hängt davon ab, welche Gehirnregionen beteiligt sind – und wie komplex die Aufgaben sind. Und genau das kannst du trainieren! Meist bedeutet Multitasking nämlich nicht echtes Parallelarbeiten, sondern sehr schnelles Umschalten zwischen Aufgaben (Task Switching). Das klappt am besten, wenn verschiedene Gehirnareale beteiligt sind – so besagt es das Modell der multiplen Ressourcen. Werden jedoch dieselben Areale beansprucht oder ist eine Aufgabe sehr komplex, steigt die Fehleranfälligkeit. Selbst das Gedächtnis kann darunter leiden. Für effektives Multitasking muss es nämlich ein Gleichgewicht zwischen Stabilität (Aufmerksamkeit) und Flexibilität (Anpassungsfähigkeit) geben. Diese Stabilität lässt sich durch Automatisierung – also gezieltes Training – verbessern. Je besser das Gehirn bestimmte Abläufe verinnerlicht hat, desto weniger Ressourcen werden benötigt. Es arbeitet stabiler – und dann kann Multitasking tatsächlich funktionieren. Wie euch ein sogenannter Hinweisreiz beim Multitasken zusätzlich unterstützen kann, erklärt euch Ralph Caspers in diesem Video von Quarks Dimension Ralph.

Kapitel 0:00 Was bedeutet Multitasking? 1:30 Modell der multiplen Ressourcen 2:44 Handy am Steuer: Multitasking im Alltag 3:35 komplexe Aufgaben: Grenzen von Multitasking 4:10 Task Switching: Multitasking ist Aufgabenwechsel 4:40 Switching Costs: Multitasking kostet Zeit 5:34 Schokoladenmoussetorte: ein Rezept für Multitasker 6:22 Fehler und schlechtere Erinnerung durch Multitasking 7:00 Stabilitäts-Flexibilitäts-Dilemma 7:58 ANCM-Prinzip: Fehler vermeiden durch Priorisierung 8:53 Automatisierung: Multitasking trainieren 9:45 Tipp: Hinweisreiz

Autor:innen: Verena Böttcher und Ralph Caspers

Schnitt und Grafik: Anna Gold und Alfred Rehbach

Sounddesign: Florian Ebrecht

Redaktion: Nasibah Sfar

Beratung: Prof. Anja Baethge (Medical School Hamburg) und Sophie-Marie Stasch (Universität der Bundeswehr München)