Virtuelle Umgebung luftgestützter Bildauswertung

Projektbeschreibung

Im Rahmen aktueller Forschungsfragen zur aktiven Umweltwahrnehmung bei unbemannten Luftfahrzeugen spielt der Einsatz von Sensordatenverarbeitung eine immer größer werdende Rolle. Der Einsatz virtueller Sensorbildsimulationen erscheint als vielversprechendes Mittel, um die Entwicklung derartiger Systeme kostengünstig und effizient zu gestalten.

Im Rahmen aktueller Forschungsfragen zur aktiven Umweltwahrnehmung bei unbemannten Luftfahrzeugen spielt der Einsatz von Sensordatenverarbeitung eine immer größer werdende Rolle. Der Einsatz virtueller Sensorbildsimulationen erscheint als vielversprechendes Mittel, um die Entwicklung derartiger Systeme kostengünstig und effizient zu gestalten.

Umfangreiches Bildmaterial zum Training, zum Test und nicht zuletzt zur Qualifizierung von Bildverarbeitungsalgorithmen muss in der Regel durch aufwendige und kostenintensive Flugversuche gewonnen werden. Diese haben zudem den Nachteil, dass sie nur eine geringe szenarische Varianz abdecken.

Daher soll in diesem Projekt der Ansatz verfolgt werden, für diesen Zweck synthetisch generierte Datensätze zu verwenden, die eine große Vielfalt an atmosphärischen Bedingungen und sensorischen Effekten aufweisen und zudem vergleichsweise einfach in großer Anzahl erzeugt werden können. Zum Einsatz kommen hierbei Simulationstools von PRESAGIS

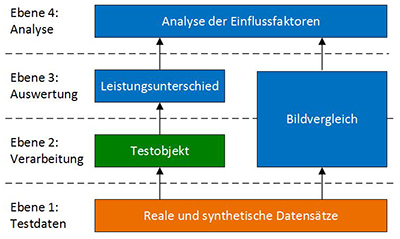

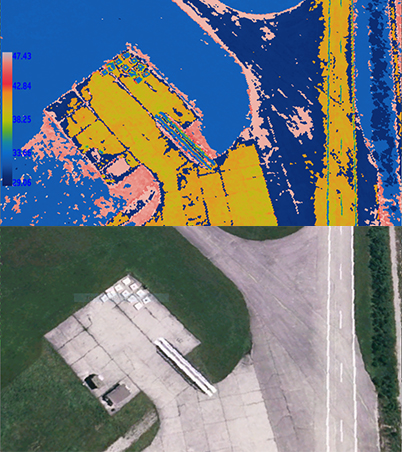

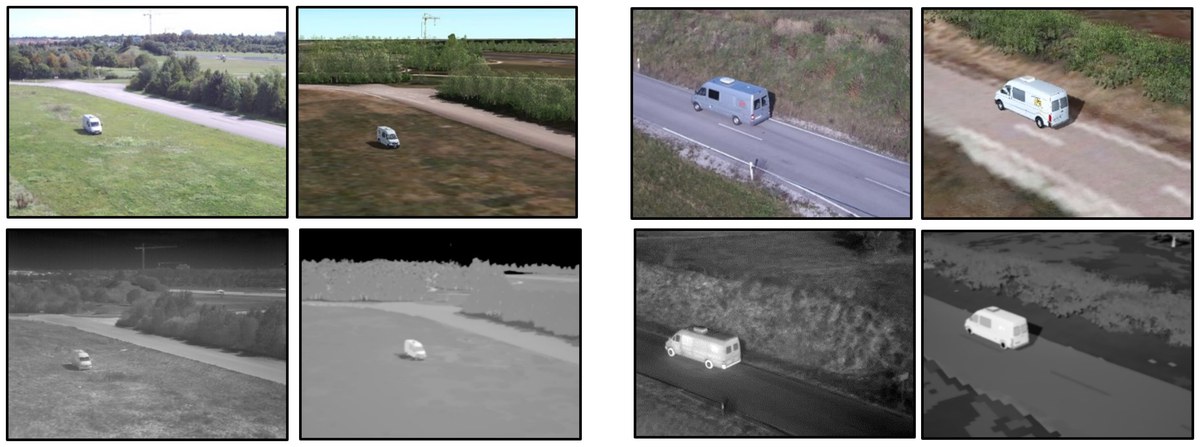

In dem Projekt wird die Leistungsfähigkeit von Bildverarbeitungsroutinen zur Objekterkennung auf synthetischem Bildmaterial und auf realen Sensordaten im visuellen und langwelligen Infrarot-Bereich unter verschiedenen Umweltbedingungen verglichen und eine Optimierung der Simulationsumgebung angestrebt.

In dem Projekt wird die Leistungsfähigkeit von Bildverarbeitungsroutinen zur Objekterkennung auf synthetischem Bildmaterial und auf realen Sensordaten im visuellen und langwelligen Infrarot-Bereich unter verschiedenen Umweltbedingungen verglichen und eine Optimierung der Simulationsumgebung angestrebt.

Bei der Verwendung synthetischer Sensordaten für Training und Test moderner, deep-learning basierter Bildverarbeitungsroutinen kann in vielen Fällen ein Leistungsunterschied im Vergleich zu realen Sensordaten beobachtet werden, der als Reality Gap bezeichnet wird. Ziel in diesem Projekt ist die Untersuchung dieses Leistungsunterschieds für Sensordaten im visuellen und im langwelligen Infrarot-Bereich und die Identifikation der zugrundeliegenden Einflussfaktoren. Diese sollen helfen Gestaltungsrichtlinien für den Einsatz virtueller Simulationsumgebungen abzuleiten.

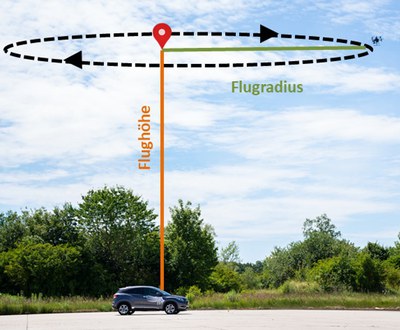

Zur detaillierten Analyse des Reality Gaps für den Anwendungsfall der UAV (Unmanned Aerial Vehicle) basierten Fahrzeugdetektion wurden auf dem Testfluggelände der Universität der Bundeswehr München mit den institutseigenen Multikoptern reale Sensordaten generiert. Mit Hilfe der aufgezeichneten Position und Blickrichtung konnten in der virtuellen Welt synthetische Duplikate erzeugt werden. Diese gekoppelten realen und synthetischen Bildpaare sollen nun dabei helfen, neue Erkenntnisse darüber zu erhalten, welche Faktoren die Detektionsleistung neuronaler Objektdetektoren beeinflussen können.

| Laufzeit: | 2017 bis 2022 |

| Projektpartner: | keine |

Beiträge zu Forschungsthemen

Dieses Projekt leistet Beiträge zu folgenden Forschungsthemen des Instituts: